Konwersja video do map 3D

Naukowcy z Massachusetts Institute of Technology (MIT) oraz National University of Ireland (NUI) w Maynooth rozwinęli nowy algorytm tworzenia szczegółowych map 3D przestrzeni otwartych i zamkniętych w czasie rzeczywistym.

Naukowcy z Massachusetts Institute of Technology (MIT) oraz National University of Ireland (NUI) w Maynooth rozwinęli nowy algorytm tworzenia szczegółowych map 3D przestrzeni otwartych i zamkniętych w czasie rzeczywistym.

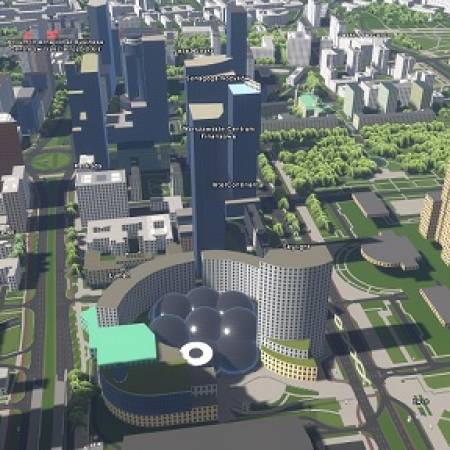

Badacze przetestowali metodę na nagraniu video wykonanym za pomocą taniego czujnika ruchu Kinect. Poruszali się m.in. po schodach i złożonych geometrycznie wnętrzach MIT Stata Centre. Zastosowawszy swoją technikę mapowania do nagrań, naukowcy wykreowali bogate, trójwymiarowe mapy. Przemieszczając się po budynku Centrum wrócili do punktu startowego, w którym rozpoczęto nagrywanie filmu. Algorytm na zasadzie podobieństwa rozpoznał to miejsce i połączył obrazy w jedną całość, przez co powstała mapowa pętla.

Technologia rozwiązuje jeden z głównych problemów map tworzonych automatycznie, który znany jest jako zamknięcie pętli lub drift. Kiedy aparat panoramuje pokój lub porusza się w dół korytarza, powstają błędy w szacowaniu przebytej drogi. Na przykład drzwi mogą być przesunięte w jednym z kierunków, a ściana wydawać się wyższa niż jest w rzeczywistości. Przy relatywnie długich dystansach błędy te mogą się nakładać doprowadzając do sytuacji, kiedy ściany i schody są poprzesuwane.

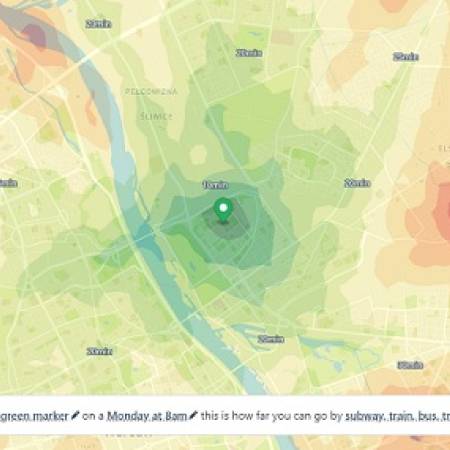

Nowa technika odwzorowania określa sposób łączenia map poprzez śledzenie pozycji aparatu w trakcie pracy w przestrzeni. Gdy obiektyw obraca się w stronę miejsca, w którym już był, algorytm określa, które punkty aktualnego widoku ma poprawić, bazując na wykonanej uprzednio w tym miejscu mapie. Technologia ta może być użyta również w nauczaniu robotów poruszających się w potencjalnie niebezpiecznych i nieznanych warunkach. Profesor John Leonard z Laboratorium Informatyki i Sztucznej Inteligencji MIT ma także plany stworzenia przyjaznej aplikacji, która dopełniłaby istnienie modelu.

Leonard oraz pozostali członkowie zespołu - Thomas Whelan, Michael Kaess z MIT i John McDonald z NUI będą prezentować wyniki swojej pracy na Międzynarodowej Konferencji Inteligentnych Robotów i Systemów, która odbędzie się w dniach od 3 do 8 listopada w Tokio.

Problem z milionem kolorów

Czujnik Kinect wytwarza kolorowy obraz wraz z informacją o rozmieszczeniu każdego piksela. Informację o położeniu piksela sensory głębi wykorzystują do jej pomiaru, rejestrując w ten sposób głębię każdego pojedyńczego piksela na obrazie. Wiadomość ta może być następnie wykorzystana przez aplikację do generowania trójwymiarowej reprezentacji dwuwymiarowego obrazu.

W 2011 roku zespół złożony z pracowników Imperial College London i Microsoft Research rozwinął aplikację do mapowania 3D nazwaną KinectFusion, która w czasie rzeczywistym, na podstawie danych z czujnika Kinect wytwarza modele 3D. Grupa z MIT i NUI rozwinęła prace tamtego zespołu w kierunku budowy algorytmu do tworzenia wysokorozdzielczych map 3D. Map, które obejmowałyby przestrzeń wielu setek metrów, w różnych środowiskach i również w czasie rzeczywistym. Cel, z punktu widzenia danych źródłowych do takiej mapy, wydawał się być ambitny. Przestrzeń obejmująca zasięgiem setki metrów zawiera miliony punktów w reprezentacji trójwymiarowej. Do wygenerowania dokładnej mapy potrzebna jest wiedza o tym, jak te punkty przesiewać, jak wybierać istotne, a pomijać mniej ważne, które nie wnoszą do obrazu wiele, a w dużej ilości mocno obniżają pracę modelu. Poprzedni zespół rozwiązał ten problem przez wielokrotną analizę danych, co jest podejściem niepraktycznym jeśli ma się na celu stworzenia mapy w czasie rzeczywistym.

Odwzorowanie przez przekroje

Leonard, Whelan i ich zespół wymyślili metodę dużo szybszą, którą można opisać na dwa sposoby: front end (przedni koniec) oraz back end (tylny koniec).

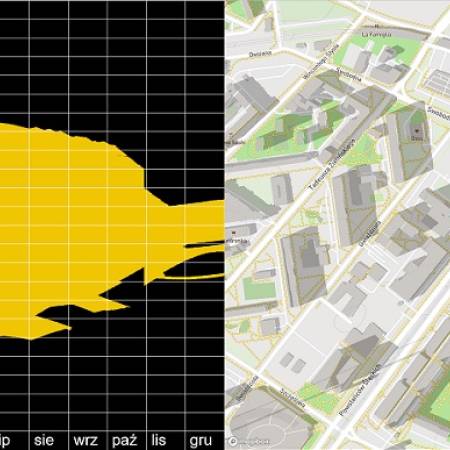

W metodzie front end algorytm śledzi pozycję kamery w ustalonym momencie jej ruchu. Jeśli czujnik Kinect pracuje w częstotliwości 30 klatek na sekundę, algorytm mierzy jak bardzo i w jakim kierunku obiektyw poruszał się pomiędzy każdą klatką. W tym samym czasie budowany jest model 3D składający się tzw. cloud slieces - przekrojów zawierających tysiące punktów najbliższego otoczenia w trójwymiarze. Każdy przekrój jest niejako przynależny do konkretnego umiejscowienia kamery. Kiedy porusza się ona na przykład po korytarzu, przekroje są składane w dużą mapę 3D reprezentującą większy, widziany niby oczami lecącego ptaka widok.

W metodzie back end algorytm bierze pod uwagę wszystkie pozycje kamery, które zostały zarejestrowane i ustawia je w miejscach, które wyglądają znajomo. Następnie automatycznie dopasowuje do nich wcześniej utworzone przekroje wraz z ich tysiącami punktów. Jest to metoda szybka, która unika określania ścieżki ruchu punkt po punkcie.

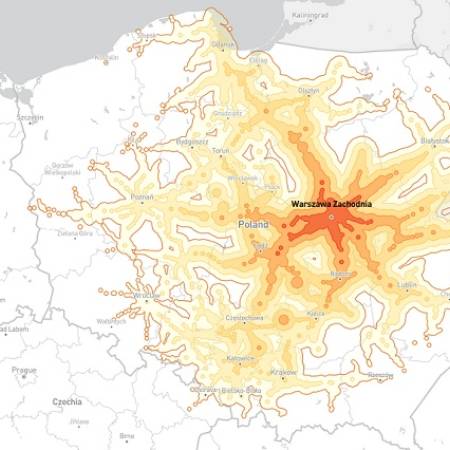

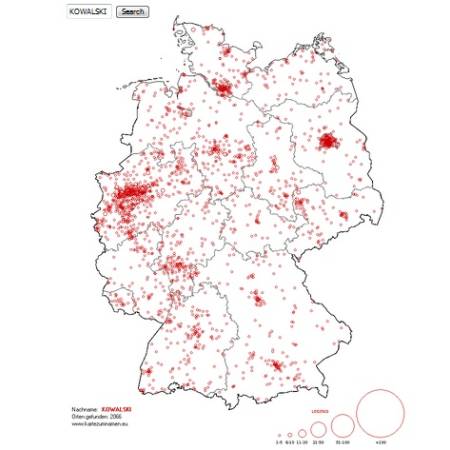

Wypracowana technologia została zastosowana do wykonania map 3D przestrzeni otwartych i zamkniętych w Londynie, Sydney, w Niemczech i Irlandii. Zastosowanie systemu w robotach miałoby pozwolić na zbieranie bardziej szczegółowej informacji o otoczeniu, przez co mogłyby one wykonywać bardziej precyzyjne ruchy. Profesor nauk informatycznych, Kostas Daniisidis z Uniwersytetu w Pensylwanii powiedział, że widzi zastosowanie algorytmu również w innych dziedzinach. Jego implementacja w kosiarkach lub odkurzaczach automatycznych pozwoliłaby im na powrót do pozycji, w której już były, bez potrzeby zapamiętywania konkretnych miejsc. Podobnie z łazikiami, które wykonują misje na przykład na Marsie.

Źródło: web.mit.edu